IT培训网 - IT职场人学IT技术上IT培训网

聊聊大数据工程师必须掌握的HDFS技术

时间:2018-03-08 17:54:44 来源:Java培训网 作者:IT培训网 已有:名学员访问该课程

大数据工程师必须掌握一定的技能才能得到企业的青睐,有关HDFS技术是大数据中的一项过硬技术,大数据工程师掌握了这个要领,那就相当于闯过了一个难关,究竟什么是HDFS技术?我们随IT培训网小编一起看看。

1、什么是HDFS?

设计思想:分而治之:将大文件、大批量文件,分布式存放在大量服务器上,以便于采取分而治之的方式对海量数据进行运算分析;

在大数据系统中作用:为各类分布式运算框架(如:mapreduce,spark,tez,……)提供数据存储服务

重点概念:文件切块,副本存放,元数据

重要特性如下:

⑴ HDFS中的文件在物理上是分块存储(block),块的大小可以通过配置参数( dfs.blocksize)来规定,默认大小在hadoop2.x版本中是128M,老版本中是64M

⑵ HDFS文件系统会给客户端提供一个统一的抽象目录树,客户端通过路径来访问文件,形如:hdfs://namenode:port/dir-a/dir-b/dir-c/file.data

⑶ 目录结构及文件分块信息(元数据)的管理由namenode节点承担——namenode是HDFS集群主节点,负责维护整个hdfs文件系统的目录树,以及每一个路径(文件)所对应的block块信息(block的id,及所在的datanode服务器)

⑷ 文件的各个block的存储管理由datanode节点承担---- datanode是HDFS集群从节点,每一个block都可以在多个datanode上存储多个副本(副本数量也可以通过参数设置dfs.replication)

⑸ HDFS是设计成适应一次写入,多次读出的场景,且不支持文件的修改

2、HDFS的shell(命令行客户端)操作

HDFS集群分为两大角色:NameNode、DataNode

NameNode负责管理整个文件系统的元数据

DataNode 负责管理用户的文件数据块

文件会按照固定的大小(blocksize)切成若干块后分布式存储在若干台datanode上

每一个文件块可以有多个副本,并存放在不同的datanode上

Datanode会定期向Namenode汇报自身所保存的文件block信息,而namenode则会负责保持文件的副本数量

HDFS的内部工作机制对客户端保持透明,客户端请求访问HDFS都是通过向namenode申请来进行

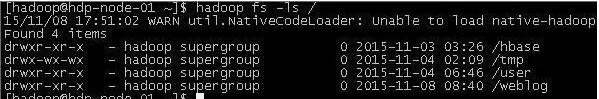

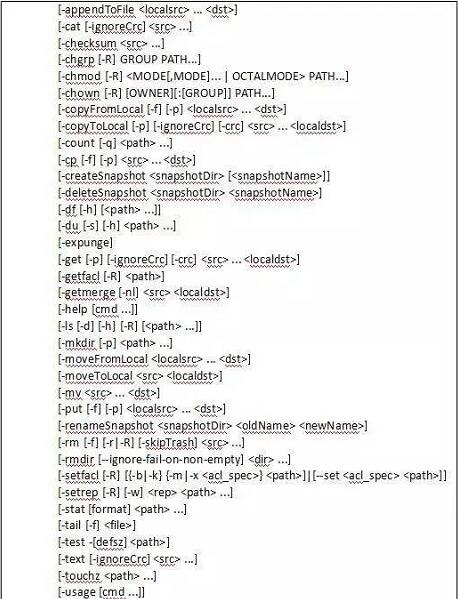

HDFS提供shell命令行客户端,使用方法如下:

3、HDFS写读数据流程

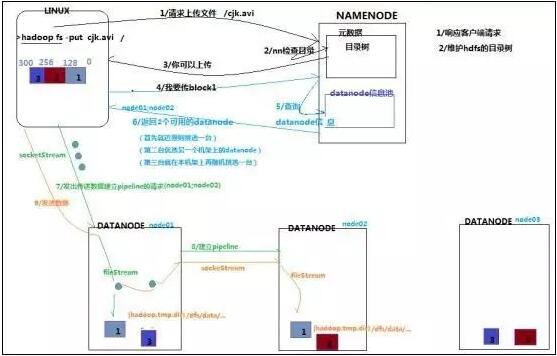

写数据

1根namenode通信请求上传文件,namenode检查目标文件是否已存在,父目录是否存在

2namenode返回是否可以上传

3client请求第一个 block该传输到哪些datanode服务器上

4namenode返回3个datanode服务器ABC

5client请求3台dn中的一台A上传数据(本质上是一个RPC调用,建立pipeline),A收到请求会继续调用B,然后B调用C,将真个pipeline建立完成,逐级返回客户端

6client开始往A上传第一个block(先从磁盘读取数据放到一个本地内存缓存),以packet为单位,A收到一个packet就会传给B,B传给C;A每传一个packet会放入一个应答队列等待应答

7当一个block传输完成之后,client再次请求namenode上传第二个block的服务器

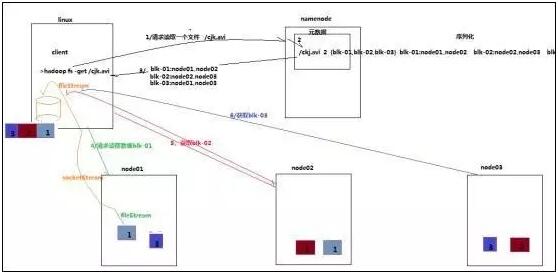

读数据

1跟namenode通信查询元数据,找到文件块所在的datanode服务器

2挑选一台datanode(就近原则,然后随机)服务器,请求建立socket流

3datanode开始发送数据(从磁盘里面读取数据放入流,以packet为单位来做校验)

4客户端以packet为单位接收,现在本地缓存,然后写入目标文件

HDFS上的文件也被划分为块大小的多个分块(chunk),作为独立的存储单元。但与其他文件系统不同的是,HDFS中小于一个块大小的文件不会占据整个块的空间。

每期开班座位有限.0元试听抢座开始!

每期开班座位有限.0元试听抢座开始!

温馨提示 : 请保持手机畅通,咨询老师为您

提供专属一对一报名服务。

Java5保姆级教学方式,你适

Java5保姆级教学方式,你适 跳槽季节来啦,学Java的伙

跳槽季节来啦,学Java的伙 你认为Java,Go和Python那个

你认为Java,Go和Python那个 你认为Java,Go和Python那个

你认为Java,Go和Python那个 说起Java编程这个功能简单

说起Java编程这个功能简单 郑州哪家Java培训机构学

郑州哪家Java培训机构学 Java不常见的面试题你知道

Java不常见的面试题你知道 作为程序员,跳槽就是最

作为程序员,跳槽就是最 一般学JAVA开发的能做得了

一般学JAVA开发的能做得了 石家庄十大java培训机构排

石家庄十大java培训机构排 Java程序员薪水高待遇好 难道jav

Java程序员薪水高待遇好 难道jav 那些对java学习有用的经典书籍你

那些对java学习有用的经典书籍你 大数据发展势不可挡 南阳大数据

大数据发展势不可挡 南阳大数据 一分钟学会什么是Ajax及Ajax请求的

一分钟学会什么是Ajax及Ajax请求的 汇总Java程序员精选笔试题及答案

汇总Java程序员精选笔试题及答案 大数据常见数据类型有哪几种

大数据常见数据类型有哪几种